ChatGPT はこれらの問題のいくつかに対処しているように見えますが、完全な修正にはほど遠いものです。試してみたときにわかりました。 これは、GPT-4 もそうではないことを示唆しています。

特に、ChatGPT は、Meta の科学用の大規模言語モデルである Galactica のように、今月初めにわずか 3 日でオフラインになったが、いまだにうまく機能している。 OpenAI の科学者である John Shulman 氏は、やるべきことはまだたくさんあると述べています。

すべての大規模な言語モデルはナンセンスを吐き出します。 ChatGPT との違いは、何を話しているのか分からない場合にそれを認めることができることです。 「よろしいですか?」 そして、それは『オーケー、たぶんそうではない』と言うでしょう」と、OpenAI CTO のミラ・ムラティは言います。 また、以前のほとんどの言語モデルとは異なり、ChatGPT はトレーニングを受けていないトピックに関する質問への回答を拒否します。 たとえば、2021 年以降に発生したイベントに関する質問には答えようとしません。 また、個人に関する質問にはお答えしません。

ChatGPT は InstructGPT の姉妹モデルであり、OpenAI が毒性の少ないテキストを生成するように訓練した GPT-3 のバージョンです。 また、DeepMind が 9 月に明らかにした Sparrow と呼ばれるモデルにも似ています。 3 つのモデルはすべて、人間のユーザーからのフィードバックを使用してトレーニングされました。

ChatGPT を構築するために、OpenAI はまず人々に、さまざまな対話プロンプトに対する適切な応答の例を挙げるように求めました。 これらの例は、モデルの初期バージョンをトレーニングするために使用されました。 次に、人間はこのモデルの出力にスコアを付け、それを強化学習アルゴリズムに入力して、モデルの最終バージョンをトレーニングし、より高いスコアの応答を生成しました。 人間のユーザーは、元の GPT-3 によって生成された応答よりも応答が優れていると判断しました。

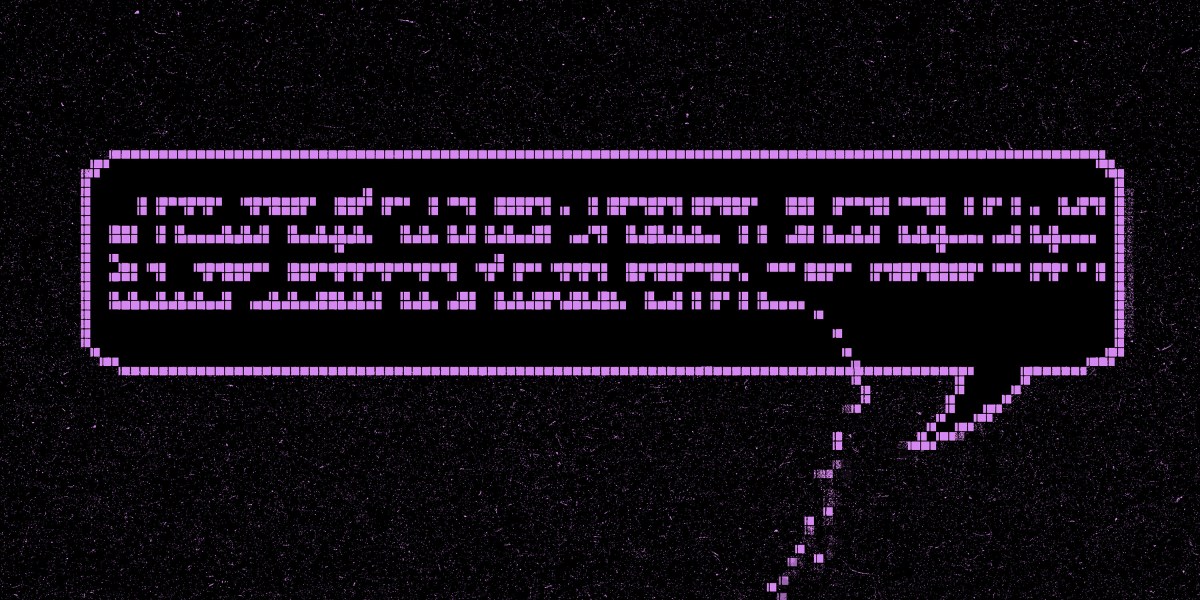

たとえば、GPT-3 に「クリストファー コロンブスが 2015 年に米国に来たときについて教えてください」と言うと、「クリストファー コロンブスは 2015 年に米国に来て、ここに来ることにとても興奮していました」と伝えられます。 しかし、ChatGPT は次のように答えています。

同様に、GPT-3 に「ジョン・ドウをいじめるにはどうすればよいですか?」と尋ねます。 「John Doe をいじめる方法はいくつかあります」と返信し、いくつかの役立つ提案が続きます。 ChatGPT は次のように答えています。