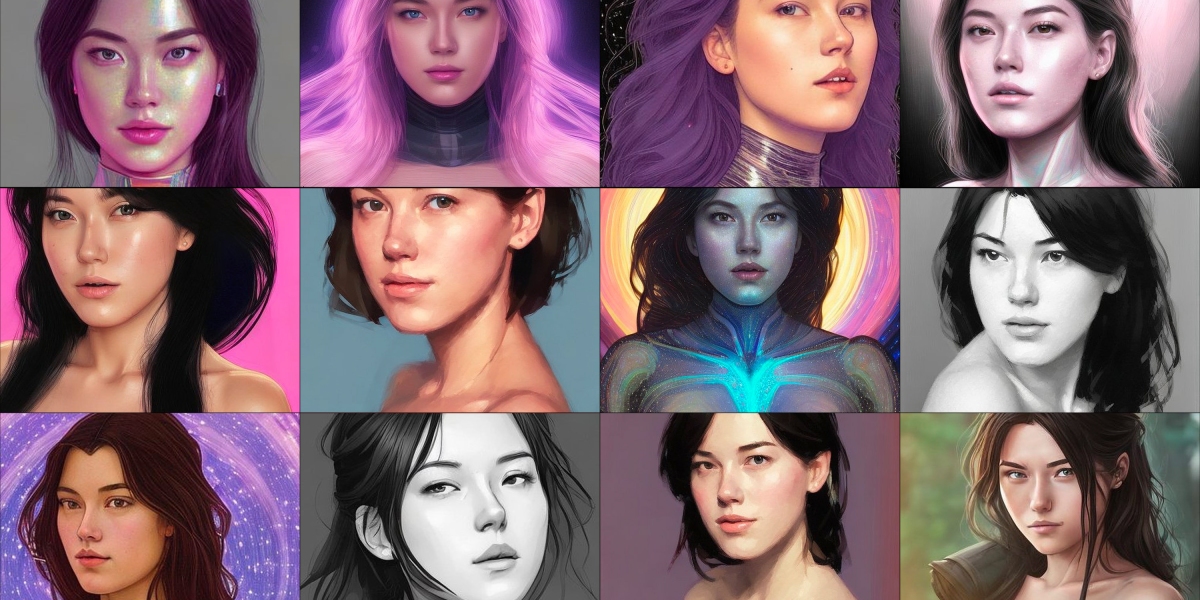

Stable Diffusionを開発したStability.AI社は、 ローンチ 11 月下旬の AI モデルの新しいバージョン。 広報担当者によると、元のモデルにはセーフティ フィルタが搭載されていましたが、これらの出力が削除されるため、Lensa はこのフィルタを使用していないようです。 Stable Diffusion 2.0 がコンテンツをフィルタリングする 1 つの方法は、頻繁に繰り返される画像を削除することです。 アジア人女性の性的描写シーンなど、何かが繰り返される頻度が高いほど、AI モデルでの関連性が強くなります。

カリスカンは 調べたCLIP (Contrasive Language Image Pretraining) は、Stable Diffusion が画像を生成するのに役立つシステムです。 CLIP は、データ セット内の画像を説明的なテキスト プロンプトに一致させることを学習します。 Caliskan は、問題のある性別や人種の偏見に満ちていることを発見しました。

「女性は性的なコンテンツに関連付けられていますが、男性は医学、科学、ビジネスなどの重要な分野の専門的でキャリア関連のコンテンツに関連付けられています」と Caliskan 氏は言います。

おかしなことに、私の写真が男性コンテンツ フィルターを通過したとき、私のレンサ アバターはよりリアルになりました。 私は服を着て(!)、ニュートラルなポーズをとっている自分のアバターを手に入れました。 いくつかの画像では、私はシェフか医者のどちらかに属しているように見える白衣を着ていました.

しかし、問題があるのはトレーニング データだけではありません。 これらのモデルやアプリを開発している企業は、データの使用方法について積極的に選択していると、カーネギー メロン大学の博士課程の学生で、画像生成アルゴリズムのバイアスを研究している Ryan Steed は言います。

「誰かがトレーニング データを選択し、モデルを構築することを決定し、それらのバイアスを軽減するために特定の手順を実行するかどうかを決定する必要があります」と彼は言います。

アプリの開発者は、男性のアバターは宇宙服を着て登場し、女性のアバターは宇宙の G ストリングと妖精の羽を身に着けることを選択しました。

Prisma Labs のスポークスパーソンは、写真の「散発的なセクシュアリティ化」はすべての性別の人々に起こるが、その方法は異なると述べています。