画像生成の分野は急速に変化しています。 Midjourney や Stable Diffusion などの人気のあるツールで使用される拡散モデルは、私たちが持っている最高のもののように思えるかもしれませんが、次のものが常に来ています。 DALL-E などよりも桁違いに高速です。

紙は 先月プレプリントとしてオンラインに掲載、控えめなファンファーレ OpenAI のメジャー リリースの準備金は伴わなかった. 当然のことですが、これは間違いなく単なる研究論文であり、非常に技術的なものです。 しかし、この初期の実験的手法の結果は注目に値するほど興味深いものです。

一貫性モデルを説明するのは特に簡単ではありませんが、拡散モデルと比較するとより理にかなっています。

拡散では、モデルは、完全にノイズで構成された開始画像からノイズを徐々に差し引く方法を学習し、段階的にターゲット プロンプトに近づけます。 このアプローチは、今日の最も印象的な AI 画像を可能にしましたが、基本的に、良い結果を得るには、10 から数千のステップを実行する必要があります。 つまり、運用コストが高く、リアルタイム アプリケーションが実用的でないほど遅いということです。

一貫性モデルの目標は、1 回または多くても 2 回の計算ステップで適切な結果が得られるものを作成することでした。 これを行うために、モデルは拡散モデルのように画像破壊プロセスを観察するようにトレーニングされますが、任意のレベルのあいまいな (つまり、情報がほとんどないか、または多くの情報が欠落している) 画像を取得し、完全なソース画像を生成することを学習します。ほんの一歩。

しかし、これは何が起こっているかについての最も手の込んだ説明に過ぎないことを急いで付け加えておきます。 こんな紙です。

一貫性に関する論文からの代表的な抜粋。 画像クレジット: OpenAI

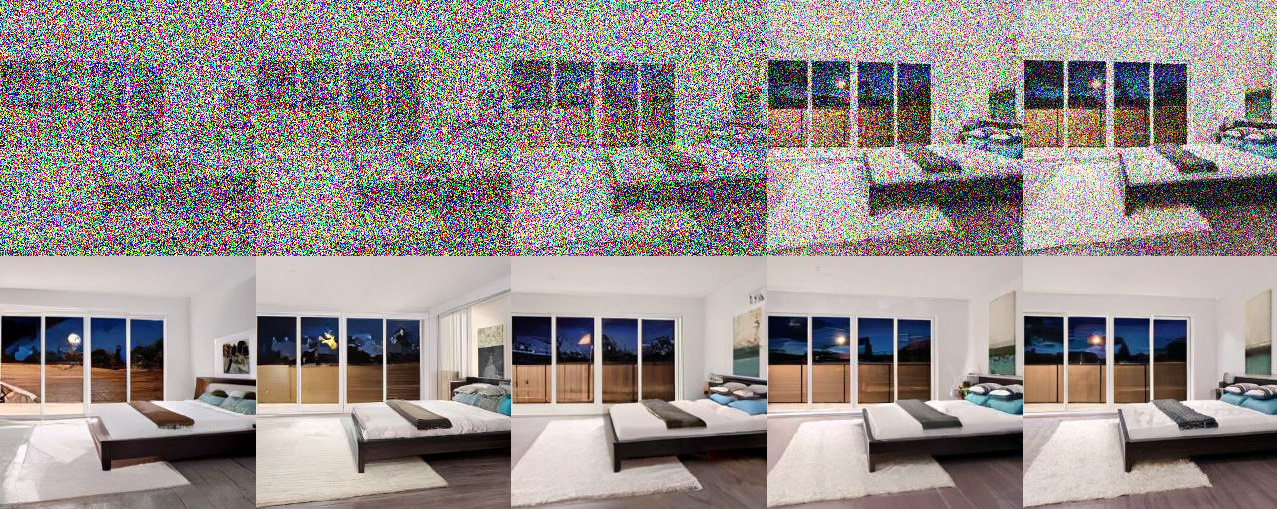

得られた画像は驚くようなものではありません。画像の多くは、良いとは言えません。 しかし重要なのは、それらが百や千ではなく、単一のステップで生成されたということです。 さらに、一貫性モデルは、色付け、アップスケーリング、スケッチの解釈、埋め込みなどの多様なタスクに一般化され、これも 1 つのステップで行われます (ただし、1 秒単位で改善されることがよくあります)。

画像の大部分がノイズであろうと大部分がデータであろうと、一貫性モデルは最終結果に直接つながります。 画像クレジット: OpenAI

これが重要なのは、まず、機械学習研究のパターンは一般に、誰かが技術を確立し、他の誰かがそれをより良く機能させる方法を見つけ、他の人が計算を追加しながら時間をかけて調整し、最初よりも大幅に優れた結果を生み出すというものだからです。 それが多かれ少なかれ、最新の拡散モデルと ChatGPT の両方にたどり着いた方法です。 実際には、与えられたタスクに多くの計算しか割くことができないため、これは自己制限的なプロセスです。

しかし、次に起こることは、以前のモデルが行ったことを実行できる、より効率的な新しい手法が特定されたことです。 一貫性モデルはこれを示していますが、拡散モデルと直接比較することはまだ十分に早い段階です。

しかし、これは、現在世界で最も影響力のある AI 研究組織である OpenAI が、次世代のユース ケースの普及をどのように積極的に見ているかを示しているため、別のレベルで重要です。

はい、GPU のクラスターを使用して 1 ~ 2 分で 1500 回の反復を実行したい場合、拡散モデルから驚くべき結果を得ることができます。 しかし、バッテリーを消耗させずに誰かの電話で画像ジェネレーターを実行したり、ライブ チャット インターフェイスなどで超高速の結果を提供したりしたい場合はどうすればよいでしょうか? 拡散は単にこの仕事には不適切なツールであり、OpenAI の研究者は適切なツールを積極的に探しています — この分野でよく知られている Ilya Sutskever を含め、他の著者である Yang Song、Prafulla Dhariwal、およびマーク・チェン。

一貫性モデルが OpenAI の次の大きなステップなのか、それともその矢筒のもう 1 つの矢なのか (未来はほぼ確実にマルチモーダルとマルチモデルの両方になる) は、研究がどのように展開するかにかかっています。 私は詳細を求めており、研究者から返事があればこの投稿を更新します.