現在最も魅力的で注目を集めている AI ツール (たとえば、OpenAI の ChatGPT、Microsoft の Bing、Google の Bard、Adobe の Photoshop) は、強力で高価なサーバーが詰め込まれたデータ センターで実行されています。 しかしインテルは月曜日、ラップトップが人工知能革命においてより大きな役割を果たすのに役立つ可能性のある、次期Meteor Lake PCプロセッサの詳細を明らかにした。

今年後半にコンピューターに搭載される予定の Meteor Lake には、バッテリーを消耗する可能性がある一部の AI タスクを高速化する回路が含まれています。 たとえば、ビデオ会議中に背景をぼかしたり置き換えたりするためのAIを改善できると、インテルのクライアントAI作業のリーダーであるジョン・レイフィールド氏は述べた。

AI モデルは、人間の脳にヒントを得た方法を使用して、複雑な現実世界のデータのパターンを認識します。 AI をクラウドではなくラップトップまたは携帯電話のプロセッサ上で実行することで、ネットワークの遅延がないため、プライバシーとセキュリティが向上するだけでなく、より機敏な応答が得られるなどのメリットが得られます。

不透明なのは、AIの仕事が実際にどれだけクラウドからPCに移行するのかということだ。 Adobe Photoshop や Lightroom などの一部のソフトウェアは、写真内の人物、空、その他の主題の検索やその他の多くの画像編集タスクに AI を広範囲に使用しています。 アプリはあなたの声を認識し、それをテキストに書き起こすことができます。 Microsoft は、Windows Copilot と呼ばれる AI チャットボットを自社のオペレーティング システムに直接組み込んでいます。 しかし、今日のほとんどのコンピューティング作業では、プロセッサのより伝統的な部分、中央処理装置 (CPU) およびグラフィックス処理装置 (GPU) コアが使用されます。

構築すれば実現する可能性があります。 スマートフォンのプロセッサや Apple M シリーズ Mac プロセッサですでに行われているように、AI アクセラレーションをチップに直接追加することで、開発者が AI 機能を活用したソフトウェアをさらに作成するようになる可能性があります。

ただし、GPU はすでに AI の高速化に非常に優れており、開発者は何百万もの人々が Windows PC をアップグレードしてそれを利用するのを待つ必要はありません。 GPU は PC 上で最高の AI パフォーマンスを提供しますが、新しい AI 専用アクセラレータは低消費電力に適しているとレイフィールド氏は述べています。 両方を同時に使用して最高のパフォーマンスを得ることができます。

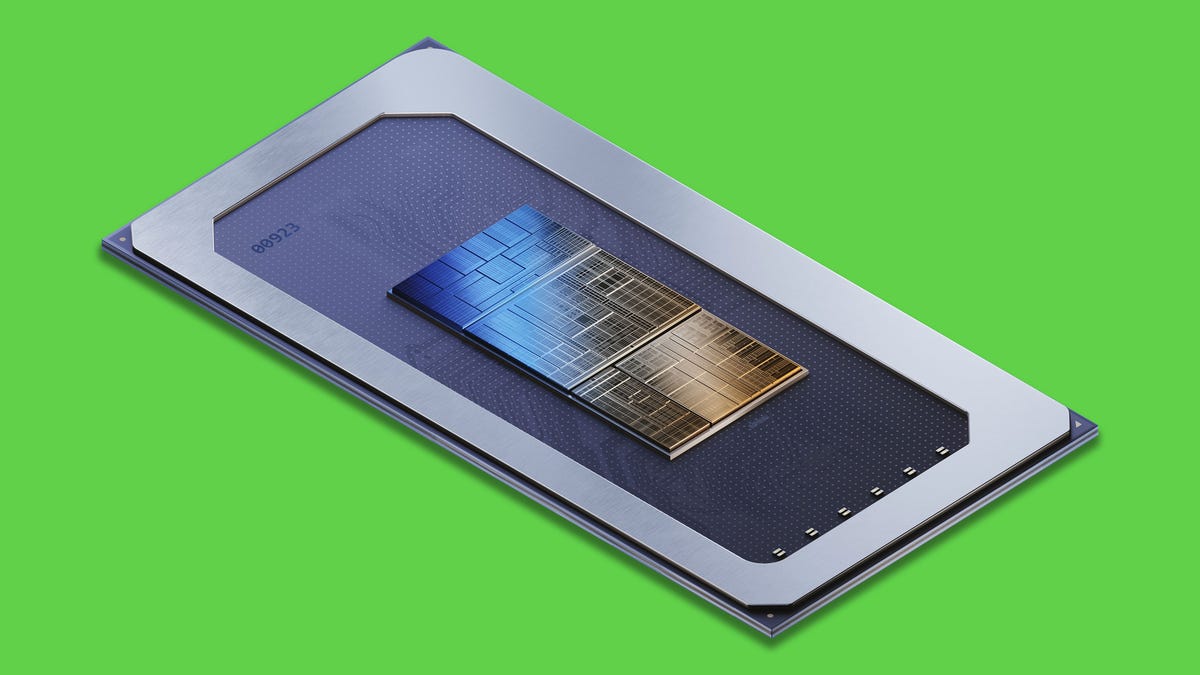

Intelの主要チップであるMeteor Lake

Meteor Lake が重要である理由は他にもあります。 これはおそらく Apple M シリーズ プロセッサと比較した唯一の最大の競争上の弱点である低電力動作向けに設計されています。 グラフィック アクセラレーションがアップグレードされており、これはゲームにとって重要であり、一部の AI タスクにとっても重要です。

このプロセッサは、インテルの長年にわたる再建努力の鍵でもある。 これは、チップ製造のリーダーである台湾積体電路製造(TSMC)やサムスンに追いつくために不可欠な新しい製造プロセスであるIntel 4で構築された初の大型チップである。 また、Foveros と呼ばれる新しい高度な製造テクノロジーを採用しており、インテルは複数の「チップレット」をより柔軟かつ経済的に単一のより強力なプロセッサーにスタックできます。

チップメーカーは AI 革命を活用しようと競い合っていますが、Nvidia ほど成功している例はほとんどありません。Nvidia は 5 月初旬に、 最高級の AI チップに対する需要が爆発的に増加している。 Intelはデータセンター用AIチップも販売しているが、パフォーマンスよりも経済性を重視している。

インテルは、自社の PC プロセッサーにおいて、AI アクセラレーターを ビジョン プロセッシング ユニット、または VPU、製品ファミリーと名前は、2016 年の AI チップメーカー Movidius の買収に由来します。

最近では、生成 AI と呼ばれるバリエーションにより、リアルな画像や人間のような音声のテキストを作成できます。 Meteor Lake はそのような画像ジェネレーターの 1 つである Stable Diffusion を実行できますが、ChatGPT のような大規模な AI 言語モデルはラップトップには適合しません。

ただし、これを変えるには多くの作業が必要です。 FacebookのLLaMA と Google の PaLM 2 は両方とも、PC やメモリがはるかに少ない携帯電話などの小型の「クライアント」デバイスにまでスケールダウンするように設計された大規模な言語モデルです。

「クラウド上の AI には、遅延、プライバシー、セキュリティという課題があり、根本的に高価です」とレイフィールド氏は述べています。 「時間の経過とともに、コンピューティング効率が向上するため、より多くのものがクライアントに移行されます。」