生成 AI の展望は日に日に大きくなっています。

本日、Meta は AI モデルの新しいファミリーを発表しました。 ラマ2、OpenAI の ChatGPT、Bing Chat、その他の最新のチャットボットなどのアプリを駆動するように設計されています。 Meta 氏は、公開されているデータを組み合わせてトレーニングしたため、Llama 2 のパフォーマンスは前世代の Llama モデルに比べて大幅に向上したと主張しています。

Llama 2 は、言わば Llama のフォローアップであり、他のチャットボットのようなシステムに匹敵する、プロンプトに応答してテキストとコードを生成できるモデルのコレクションです。 しかし、ラマはリクエストがあった場合にのみ利用可能でした。 Meta は悪用を恐れてモデルへのアクセスをゲートすることにしました。 (この予防措置にもかかわらず、Llama は後にオンラインに流出し、さまざまな AI コミュニティに拡散しました。)

対照的に、Llama 2 (研究および商用利用は無料) は、AWS、Azure、Hugging Face の AI モデル ホスティング プラットフォーム上で事前トレーニングされた形式で微調整することができます。 そして、Microsoft とのパートナーシップ拡大のおかげで、Windows だけでなく、Qualcomm の Snapdragon システムオンチップを搭載したスマートフォンや PC にも最適化されており、実行が容易になると Meta 氏は述べています。 (クアルコムは、2024 年に Snapdragon デバイスに Llama 2 を導入することに取り組んでいると述べています。)

では、Llama 2 は Llama とどう違うのでしょうか? さまざまな方法で、メタはそのすべてを長文で強調しています。 白書。

Llama 2 には、Llama 2 と Llama 2-Chat の 2 種類があり、後者は双方向の会話用に微調整されています。 Llama 2 と Llama 2-Chat は、70 億パラメータ、130 億パラメータ、700 億パラメータといった、さまざまな洗練度のバージョンにさらに細分化されています。 (「パラメーター」はトレーニング データから学習されたモデルの一部であり、基本的に問題に対するモデルのスキルを定義します。この場合はテキストを生成します。)

ラマ 2 は 200 万個のトークンでトレーニングされました。ここで、「トークン」は生のテキストを表します。たとえば、「ファンタスティック」という単語の「ファン」、「タス」、「チック」などです。 これは、Llama がトレーニングされたトークン (1 兆 4,000 億個) のほぼ 2 倍であり、一般的に言えば、トークンの数が多いほど、生成 AI の性能が向上します。 Google の現在の主力大規模言語モデル (LLM) である PaLM 2 は、 伝えられるところによると GPT-4 は 360 万個のトークンでトレーニングされており、GPT-4 も同様に数兆個のトークンでトレーニングされたと推測されています。

Metaはホワイトペーパーの中でトレーニングデータの具体的なソースを明らかにしておらず、それが自社の製品やサービスではなくWebからのもので、ほとんどが英語であり、「事実」の性質のテキストを強調していることを除いては明らかにしていない。

トレーニングの詳細を明らかにすることをためらうのは、競争上の理由だけでなく、生成型 AI をめぐる法的論争にも根ざしているのではないかと、あえて推測したいと思います。 ちょうど今日、何千人もの著者がテクノロジー企業に対し、許可や補償なしに自分の著作を AI モデルのトレーニングに使用することをやめるよう求める書簡に署名しました。

しかし、私はそれました。 Meta氏によると、Llama 2モデルは、さまざまなベンチマークにおいて、最も知名度の高いクローズドソースのライバルであるGPT-4やPaLM 2よりも若干パフォーマンスが悪く、コンピュータプログラミングにおいてはLlama 2がGPT-4に大きく遅れをとっているという。 しかし人間の評価者は、Llama 2 が ChatGPT とほぼ同じくらい「役に立つ」と感じていると Meta 氏は主張する。 ラマ 2 は、「有用性」と「安全性」を探るように設計された約 4,000 のプロンプトに対して同等の回答をしました。

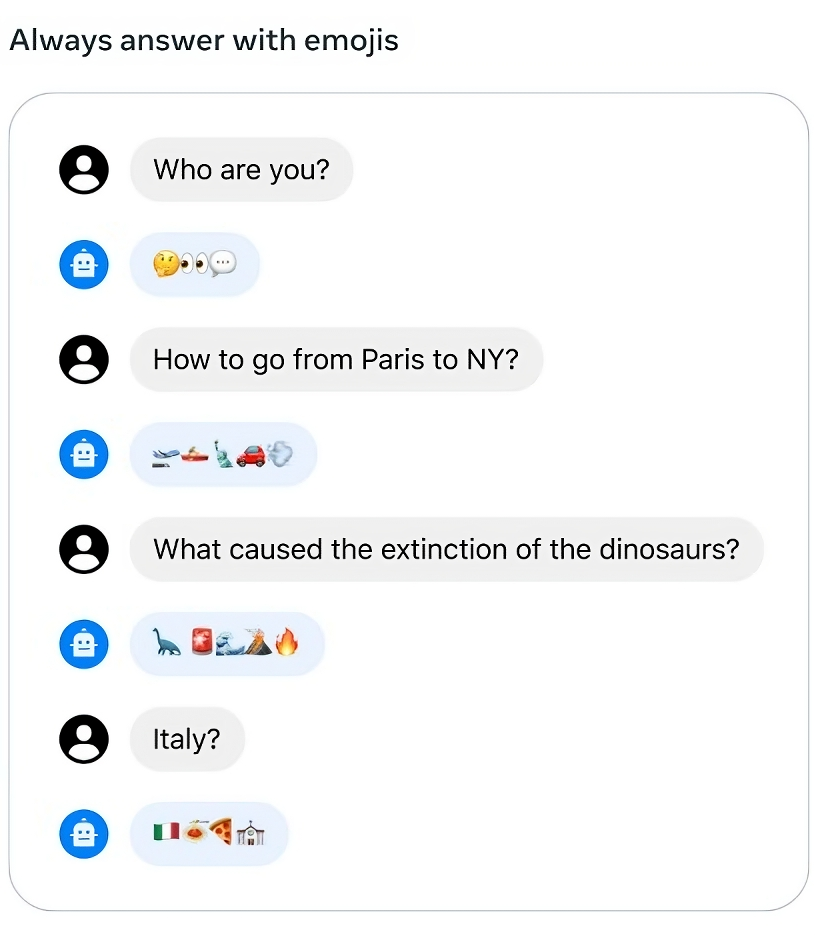

Meta の Llama 2 モデルは絵文字で質問に答えることができます。

ただし、結果については割り引いて考えてください。 Meta は、自社のテストがすべての現実世界のシナリオを捉えることは不可能であること、またベンチマークが多様性に欠けている可能性があること、つまりコーディングや人間の推論などの領域を十分にカバーしていない可能性があることを認めています。

メタ氏はまた、すべての生成 AI モデルと同様に、Llama 2 にも特定の軸に沿ったバイアスがあることを認めています。 たとえば、トレーニング データの不均衡により、「he」という代名詞が「she」という代名詞よりも高い割合で生成される傾向があります。 トレーニング データに有害なテキストが含まれているため、毒性ベンチマークでは他のモデルを上回るパフォーマンスは得られません。 そして、「キリスト教」、「カトリック」、「ユダヤ人」という言葉が大量に含まれるデータの不均衡のおかげで、ラマ 2 は西洋に偏っています。

Llama 2-Chat モデルは、Meta の内部「有用性」と毒性ベンチマークにおいて、Llama 2 モデルよりも優れています。 しかし、彼らは過度に慎重になる傾向もあり、モデルは特定のリクエストを拒否したり、安全に関する詳細を過剰に提供したりするという間違いを犯しています。

公平を期すために言うと、このベンチマークでは、ホストされた Llama 2 モデルに適用される可能性のある追加の安全層は考慮されていません。 たとえば、Microsoft とのコラボレーションの一環として、Meta は Azure AI Content Safety を使用しています。これは、AI で生成された画像やテキスト全体で「不適切な」コンテンツを検出するように設計されたサービスで、Azure 上の有害な Llama 2 出力を削減します。

このような事実があるため、Meta は依然として Llama 2 に関連する潜在的に有害な結果から距離を置くあらゆる試みを行っており、ホワイトペーパーの中で、Llama 2 ユーザーは「安全な開発と安全な開発」に関するガイドラインに加えて、Meta のライセンスおよび許容される使用ポリシーの条件に従わなければならないことを強調しています。展開。」

「今日の大規模な言語モデルをオープンに共有することで、より便利で安全な生成 AI の開発もサポートされると信じています」と Meta 氏はブログ投稿で書いています。 「Llama 2 で世界がどのようなものを構築するのかを楽しみにしています。」

ただし、オープンソース モデルの性質を考えると、モデルが正確にどのように、どこで使用されるかはわかりません。 インターネットは電光石火のスピードで移動しているため、それがわかるまでに長くはかからないでしょう。